Hemos experimentado muchos cambios en el último año. Hemos tenido la oportunidad de crecer y aumentar nuestra gama de servicios, manteniendo al mismo tiempo nuestra plataforma flexible, escalable y fácil de usar. Este viaje no es un salto, sino una serie de pasos graduales que nos hacen avanzar. Hemos estado trabajando mucho para hacer posible nuestra expansión y queremos seguir compartiendo con ustedes lo que ocurre entre bastidores.

Para sentar las bases del futuro hay que empezar por la infraestructura básica: hardware y redes. Estos aspectos pueden pasarse por alto con la vista puesta en nuevas funciones y servicios, pero una base sólida nos permitirá construir una plataforma más potente.

Más potencia: CPU más rápidas

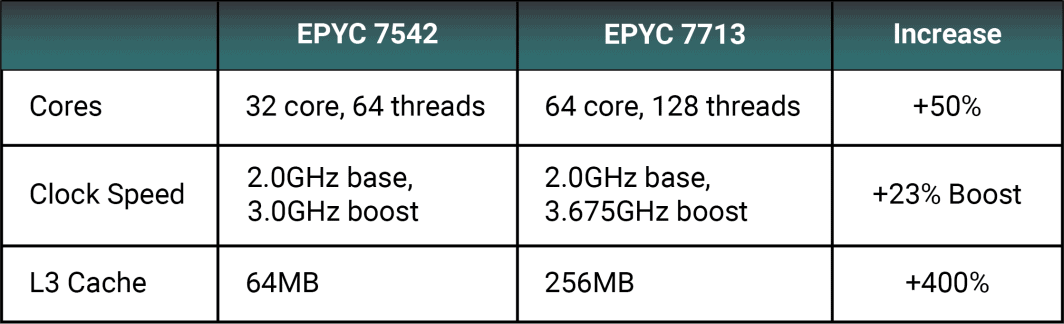

Muchas de nuestras regiones actuales cuentan ahora con CPU AMD EPYC™ 7713. Podemos compararlo con uno de los procesadores Zen 2 más comunes de nuestra flota actual, el 7542, y seguir observando un aumento sustancial del rendimiento bruto.

Un aumento del 23% en la velocidad de reloj de refuerzo permitirá acomodar cargas de trabajo más exigentes. Un mayor número de núcleos reduce la posible contención de recursos y los cuellos de botella de las instrucciones que se ejecutan en un único motor de ejecución.

La caché L3 ha aumentado nada menos que un 400% al pasar de 64 MB a 256 MB. Una mayor caché L3 evita que la CPU recurra con frecuencia a la RAM en busca de datos. La RAM sigue siendo más rápida que la mayoría de los formatos de almacenamiento, pero la caché de la CPU está integrada en el procesador y es mucho más rápida que la RAM. Una caché L3 más grande aumenta el rendimiento de las aplicaciones que consumen mucha memoria, como los juegos y la codificación de vídeo.

Almacenamiento estándar de alta velocidad

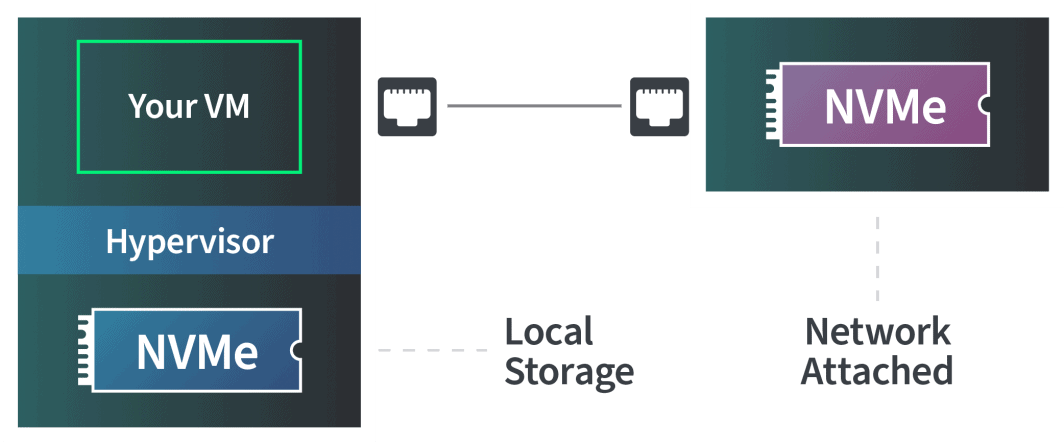

En 2021 implementamos todo el almacenamiento en bloque NVMe, que ofrece mejoras de rendimiento significativas con respecto a los discos giratorios o incluso las SSD SATA, pero eso es solo una parte de la historia. Nuestros planes informáticos incluyen almacenamiento local de serie, algo poco habitual en otros proveedores, que solo ofrecen almacenamiento temporal o conectado.

El almacenamiento en bloque separa los datos en "bloques" uniformes, lo que lo hace ideal para sistemas de archivos de alto rendimiento que deben distribuirse entre varias máquinas virtuales o hosts. El almacenamiento en bloque suele utilizarse de forma local, lo que significa que una máquina virtual se encuentra en el mismo hardware al que está conectado directamente el almacenamiento o como almacenamiento conectado a la red (NAS).

En cualquiera de las dos configuraciones se obtiene un alto rendimiento, pero hay una gran diferencia entre utilizar un disco conectado físicamente a la misma placa base en la que se ejecuta el servidor o un dispositivo NAS conectado a través de Ethernet.

Con dos discos NVMe idénticos, siempre obtendrá un mayor rendimiento del almacenamiento local que del NAS. Sin embargo, NAS es más flexible y permite crear matrices de almacenamiento masivas a las que pueden acceder varios hosts a mayor escala. Nuestros planes incluyen almacenamiento local, y ofrecemos almacenamiento en bloque adicional que puede conectarse a una máquina virtual, todo ello mediante NVMe.

Controladoras RAID por software

KVM se convirtió en nuestro hipervisor principal en 2015, cuando cambiamos de Xen. KVM mejoró significativamente el rendimiento de las máquinas virtuales utilizando el mismo hardware. En la actualidad, seguimos desarrollando la virtualización del núcleo de Linux con controladoras RAID por software como parte de nuestras nuevas versiones.

Las controladoras RAID por hardware se consideraban antes más rápidas que las configuraciones por software, pero las CPU más rápidas proporcionan a las controladoras por software un rendimiento similar, si no mejorado, con respecto a sus homólogas por hardware. Como parte de nuestras construcciones en nuevos centros de datos, ahora utilizamos los controladores de múltiples dispositivos (MD) y de bloques del kernel de Linux.

Las controladoras RAID por software de Linux se gestionan a través de mdadm y otorgan a nuestras configuraciones un mayor nivel de flexibilidad, incluyendo capacidades integradas de intercambio en caliente sin necesidad de un chasis de intercambio en caliente. Estas configuraciones ejecutan comprobaciones regulares de consistencia y realizan correcciones automáticas de sectores defectuosos.

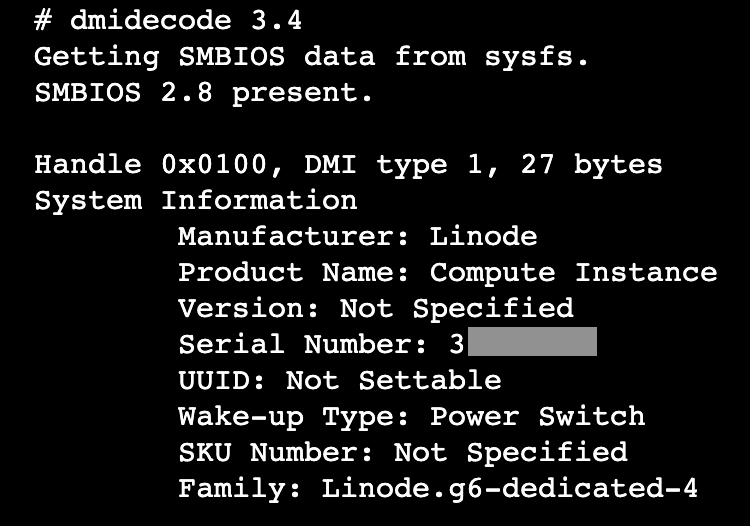

SMBIOS

Desde octubre de 2022, nuestros hosts están equipados con System Management BIOS (SMBIOS). SMBIOS permite a los usuarios consultar la base de datos de FIM y recuperar información sobre la instancia de cálculo. Siempre que su instancia haya arrancado/rearrancado desde que añadimos esto, puede utilizar el comando dmidecode para encontrar el tipo de instancia y el ID.

Corre:

dmidecode -t1

Anteriormente, esta información no estaba disponible bajo demanda, pero ahora puede extraerse del terminal en cualquier momento. Esto no sustituye a una API de metadatos local, pero puede ser una herramienta útil para la creación de scripts personalizados.

Y más y más

A medida que avanzamos y desarrollamos nuevos servicios, puedes esperar mejoras constantes y coherentes en todos los ámbitos. Le mantendremos informado de todos los detalles importantes y secundarios a medida que avancemos.

Recursos: Blog | Documentos técnicos | Boletín

Comentarios (3)

I’ve been a linode customer since April 2004, where it was a UserModeLinux (UML) based system, with a whopping 64Mb RAM and 3Gb disk (plus 1.5Gb disk for paying yearly).

Over the past 19 years your upgrades have meant I now have 4Gb RAM, 2CPUs, 80GB storage. A massive increase. All for the same price (well, until next month, anyway).

It’s good to see linode keeping up the tradition of improving the service!

The complicate one is when Linode instand got bigger storage than the current one.

It’s really hard to resize.

What if we need only create server capacity without increase storage?

What if we need only crease storage but not server capacity?

Jirou:Thanks for the suggestion! We’ve added it to our internal tracker and have passed along your feedback to our team. This way, the relevant teams can keep this in mind as we continue to improve our infrastructure and services.