Oft kommt es zu einem scheinbar plötzlichen Sprung in der Nutzung und den damit verbundenen technologischen Fortschritten, einfach weil das, was früher undurchführbar war, jetzt praktisch ist. Die Zunahme von Big-Data-Anwendungen folgt dicht auf die Verbreitung des Cloud-Computing. Im Folgenden wird erläutert, was Big Data ist, warum es heute so wichtig ist und wie es sich im Zusammenspiel mit NoSQL-Datenbanken entwickelt hat. Wenn wir von Big Data sprechen, haben wir es mit riesigen Mengen an Informationen zu tun, die wir betrachten oder analysieren können, um etwas Relevantes zu finden.

Big Data weist in der Regel drei Merkmale auf, die jeweils durch die 3 Vs gekennzeichnet sind.

- Volumen- Wir haben eine große Menge an Daten.

- Schnelligkeit- Unsere Daten kommen schnell herein.

- Vielfalt- Unsere Daten liegen in vielen verschiedenen Formen vor.

Wir wollen uns ansehen, wie wir an so viele Daten kommen, welche Arten von Daten es gibt und welchen Wert wir daraus ziehen können.

Ziehen von Schlussfolgerungen

Wir brauchen große Datensätze, um zugrundeliegende Muster zu finden, da kleine Datensätze die reale Welt nur unzuverlässig wiedergeben. Stellen Sie sich vor, Sie machen eine Umfrage unter 10 Personen: Acht von ihnen haben Android-Telefone, zwei haben iPhones. Bei dieser kleinen Stichprobengröße würde man hochrechnen, dass Apple nur einen Marktanteil von 20 % hat. Dies ist kein gutes Abbild der realen Welt.

Es ist auch wichtig, Informationen aus verschiedenen demografischen Gruppen und Orten zu erhalten. Die Befragung von 10 Personen aus Philadelphia, Pennsylvania, sagt nicht viel über die Welt, die Vereinigten Staaten oder sogar den Bundesstaat Pennsylvania als Ganzes aus. Kurz gesagt, um gute, zuverlässige Daten zu erhalten, braucht man eine Menge davon. Je umfassender die Studie ist, desto mehr können wir sie aufschlüsseln und Schlussfolgerungen ziehen.

Erhöhen wir unsere Umfrage von 10 auf 100 und erfassen wir auch das Alter der Teilnehmer. Jetzt sammeln wir mehr Daten von einer größeren Stichprobe. Nehmen wir an, die Ergebnisse zeigen, dass 40 Personen Android-Telefone und 60 Personen iPhones haben. Dies ist immer noch eine sehr kleine Stichprobe, aber wir können sehen, dass eine 10-fache Zunahme der Teilnehmer zu einer signifikanten Veränderung unserer Ergebnisse um 80 Punkte führt. Aber das ist nur ein Feld der Daten aus unserem Satz. Da wir sowohl das Alter der Teilnehmer als auch die Wahl des Telefons erfasst haben, könnten wir feststellen, dass Gruppen im Alter von 10-20 oder 21-30 Jahren ein ganz anderes Verhältnis aufweisen.

Es geht um den Algorithmus

Big Data führt dazu, dass wir große Datenmengen verarbeiten müssen, die schnell und in einer Vielzahl von Formaten eingehen. Aus diesen Daten können wir zugrundeliegende Muster erkennen, die es uns ermöglichen, genaue Modelle zu erstellen, die die reale Welt widerspiegeln. Warum ist das wichtig? Genaue Modelle ermöglichen es uns, Vorhersagen zu treffen und Algorithmen zu entwickeln oder zu verbessern.

Das häufigste Beispiel für Big Data in unserem täglichen Leben ist etwas Einfaches und manchmal umstrittenes - Empfehlungsmaschinen. "Wenn du X magst, wirst du wahrscheinlich auch Y mögen!" Das ist aus der Sicht von Marketing und Werbung sicherlich nützlich, aber das ist bei weitem nicht der einzige Anwendungsfall. Big Data und Algorithmen treiben alles an, von selbstfahrenden Autos bis zur Früherkennung von Krankheiten.

In unserem kurzen Beispiel der Datenerhebung haben wir bei 100 Personen aufgehört, aber wenn man wirklich gute Daten haben will, braucht man Tausende oder Millionen von Quellen mit einer Vielzahl von unterschiedlichen Attributen. Dies wäre immer noch nicht wirklich als "Big Data" zu bezeichnen, selbst wenn wir die Stichprobengröße erweitern und eine schnelle Erfassung der Ergebnisse einrichten würden. Uns würde eines der drei Vs fehlen, nämlich die Vielfalt, und von dort kommt ein Großteil unserer Daten.

Daten-Sorten

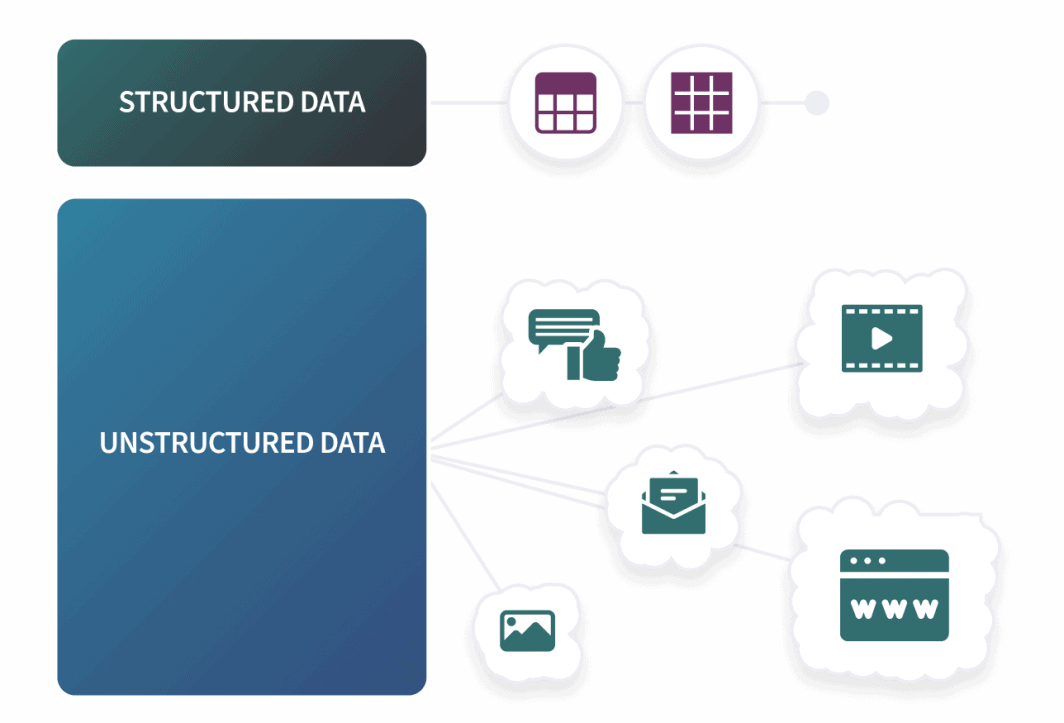

Wir können die Art der Daten, die wir sammeln, in drei grundlegende Kategorien einteilen: Strukturierte, halb-strukturierte und unstrukturierte Daten. Strukturierte Daten sind vergleichbar mit unserer obigen Umfrage. Wir haben ein vordefiniertes Schema und unsere Eingaben passen in eine feste Struktur. Diese Art von Daten eignet sich perfekt für RDBMS mit SQL, da sie für die Arbeit mit Zeilen und Spalten ausgelegt sind. Außerhalb von SQL-Datenbanken sind strukturierte Daten typischerweise csv-Dateien und Tabellenkalkulationen.

Ein Großteil der vorhandenen Daten stammt aus vielen verschiedenen Quellen, die wir bei unseren täglichen Aktivitäten auf unterschiedlichste Weise nutzen. Beiträge in sozialen Medien, Kaufhistorie, Browsing und Cookies: Jede Aktion kann ein Profil für eine Person mit zahlreichen Attributen wie Alter, Wohnort, Geschlecht, Familienstand und mehr erstellen. Wir kratzen hier nur an der Oberfläche, aber wir brauchen uns nur auf Folgendes zu konzentrieren: Die Branchen sammeln eine Menge Daten, um genaue Schlüsse zu ziehen, und die große Mehrheit dieser Daten liegt nicht in vordefinierten, strukturierten Formaten vor. Bei Big Data arbeiten wir in der Regel mit semistrukturierten und unstrukturierten Datenformen.

Anwendungsprotokolle oder E-Mails sind Beispiele für halbstrukturierte Daten. Wir bezeichnen diese Daten als halbstrukturiert, weil sie zwar nicht in starren Zeilen und Spalten vorliegen, es aber ein allgemeines Muster gibt, wie diese Daten formatiert sind. Zwei der gängigsten Dateitypen für halbstrukturierte Daten sind JSON und XML. Unstrukturierte Daten können fast alles sein, was nicht strukturiert oder halbstrukturiert ist, und wie wir uns vorstellen können, macht dies die große Mehrheit unserer Daten aus. Übliche Beispiele für unstrukturierte Daten sind Beiträge in sozialen Medien, Audio- und Videodateien, Bilder und andere Dokumente.

Unsere Telefonumfrage funktioniert immer noch als analytische Demonstration: Je mehr Daten wir haben, desto genauer werden unsere Schlussfolgerungen die reale Welt widerspiegeln, aber um tatsächlich mehr Daten zu erhalten, brauchen wir ein System, das in der Lage ist, mehr als nur strukturierte Daten aufzunehmen. An dieser Stelle kommen NoSQL-Datenbanken ins Spiel.

Große Daten und NoSQL

Das Konzept von Big Data ist seit den 1980er Jahren bekannt, und wie viele der heute am schnellsten wachsenden Technologien machte es Mitte der 2000er Jahre einen großen Schritt nach vorn. Ein Meilenstein war die Veröffentlichung von Hadoop durch Apache im Jahr 2006. Hadoop ist ein Open-Source-Software-Framework, das für die zuverlässige Verarbeitung großer Datensätze entwickelt wurde.

Zu den Kernkomponenten gehören HDFS(Hadoop Distributed File System) und YARN(Yet Another Resource Negotiator). HDFS ist ein schnelles und fehlertolerantes Dateisystem, und YARN übernimmt die Auftragsplanung und das Ressourcenmanagement. Auf HDFS läuft in den meisten Fällen HBase, eine spaltenorientierte nicht-relationale Datenbank. HBase entspricht der lockeren Definition von NoSQL, unterscheidet sich aber so sehr von den anderen populären Datenbanken, dass es normalerweise nicht auf denselben Listen wie MongoDB oder Cassandra (ein weiteres Projekt von Apache ) erscheint.

HBase kann in Verbindung mit HDFS riesige Datenmengen in Milliarden von Zeilen speichern und unterstützt spärliche Daten. Allerdings ist es nicht ohne Einschränkungen. HBase ist von HDFS abhängig, stellt hohe Anforderungen an die Hardware und verfügt nicht über eine eigene Abfragesprache. Im Gegensatz zu Mongo und Cassandra basiert HBase außerdem auf einer primären Replikationsarchitektur, die zu einem einzigen Ausfallpunkt führen kann.

Aber wir können von Anfang an sehen, warum Big Data und NoSQL zusammenpassen. Lassen Sie uns die Vs noch einmal durchgehen.

- Volumen- Big Data erfordert eine große Datenbank, und eine große Datenbank erfordert horizontale Skalierung. SQL-Datenbanken können - oft mit erheblichen Einschränkungen - horizontal skaliert werden, aber genau hier zeichnen sich die schemalosen NoSQL-Datenbanken aus.

- Geschwindigkeit- NoSQL-Datenbanken verfügen nicht über die Konsistenz und Validierung von SQL-Datenbanken, aber auch nicht über die Geschwindigkeit, die wir benötigen, um eine große Menge an Daten schnell zu erfassen.

- Vielfalt- Big Data erfordert ein System, das in der Lage ist, unstrukturierte Daten zu verarbeiten, und schemalose NoSQL-Datenbanken wie MongoDB sind für diese Aufgabe gut geeignet.

NoSQL-Datenbanken werden nicht ausschließlich für Big Data verwendet, aber wir können sehen, warum sie sich im Gleichschritt mit anderen entwickelt haben. Es gibt keine Anzeichen für eine Verlangsamung von Big Data, und die NoSQL-Datenbank MongoDB, die 2009 erstmals veröffentlicht wurde, ist eine der am schnellsten wachsenden Datenbanken auf dem Markt.

Kommentare